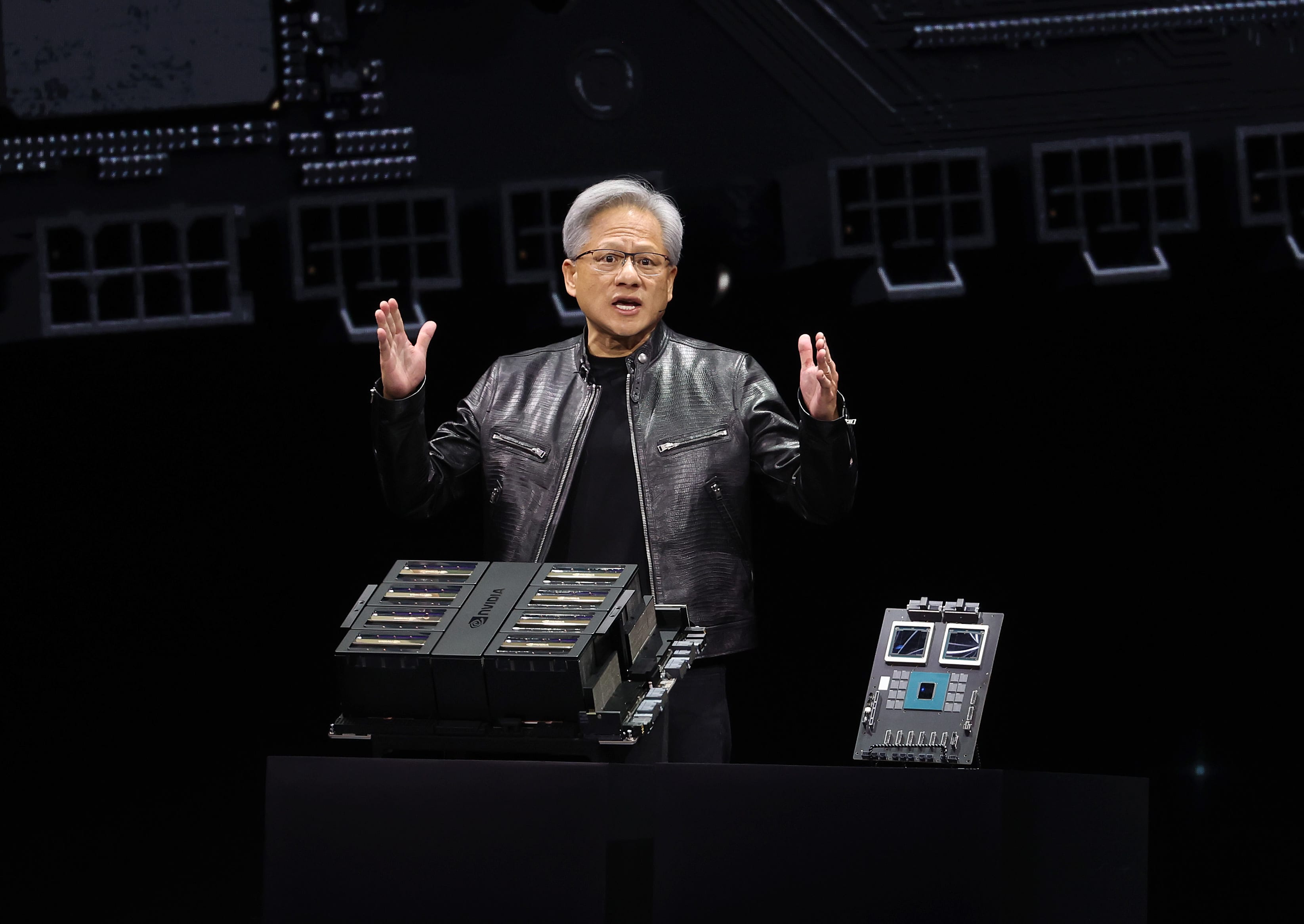

CEO Nvidia Jensen Huang menyampaikan pidato utama pada konferensi AI Nvidia GTC di SAP Center pada 18 Maret 2024 di San Jose, California.

Justin Sullivan | Gambar Getty

Prosesor grafis bertenaga AI generasi baru disebut Blackwell. Chip pertama Blackwell disebut GB200 dan akan dikirimkan akhir tahun ini. Nvidia telah memikat pelanggannya dengan chip yang lebih kuat untuk merangsang pesanan baru. Misalnya, perusahaan dan pembuat perangkat lunak masih berjuang untuk mendapatkan chip “Hopper” H100 generasi saat ini dan chip serupa.

“Hopper memang hebat, tapi kami membutuhkan GPU yang lebih besar,” kata CEO Nvidia Jensen Huang pada hari Senin di konferensi pengembang perusahaan di California.

Saham Nvidia turun lebih dari 1% dalam perdagangan yang diperpanjang pada hari Senin.

Perusahaan juga memperkenalkan program penghasil pendapatan yang disebut NIM yang akan memfasilitasi penerapan AI, memberikan pelanggan alasan lain untuk terus menggunakan chip Nvidia di tengah semakin banyaknya pesaing.

Para eksekutif Nvidia mengatakan bahwa perusahaan tersebut tidak lagi menjadi penyedia chip tentara bayaran, dan lebih menjadi penyedia platform, seperti Microsoft atau Apple, di mana perusahaan lain dapat membuat perangkat lunak.

“Blackwell bukanlah sebuah chip, itu adalah nama sebuah platform,” kata Huang.

“Produk yang dapat dijual secara komersial adalah GPU dan perangkat lunak tersebut dimaksudkan untuk membantu orang menggunakan GPU dengan cara yang berbeda,” kata Wakil Presiden Nvidia Foundation Manuvir Das dalam sebuah wawancara. “Tentu saja, kami masih melakukan hal itu. Namun yang benar-benar berubah adalah kami sebenarnya memiliki perusahaan perangkat lunak bisnis sekarang.”

Das mengatakan perangkat lunak baru Nvidia akan mempermudah menjalankan perangkat lunak pada GPU Nvidia mana pun, bahkan GPU lama yang mungkin lebih cocok untuk penerapan tetapi tidak untuk membangun AI.

“Jika Anda seorang pengembang, dan Anda memiliki model menarik yang ingin diadopsi oleh orang-orang, jika Anda memasukkannya ke dalam NIM, kami akan memastikan model tersebut dapat dimainkan di semua GPU kami, sehingga Anda dapat menjangkau banyak orang,” kata Das.

Superchip Grace Blackwell GB200 Nvidia, dengan dua GPU B200 dan satu CPU berbasis Arm.

Setiap beberapa tahun, Nvidia memperbarui arsitektur GPU-nya, sehingga menghasilkan lompatan besar dalam performa. Banyak model AI yang dirilis selama setahun terakhir telah dilatih pada arsitektur Hopper perusahaan – yang digunakan oleh chip seperti H100 – yang akan diumumkan pada tahun 2022.

Nvidia mengatakan prosesor berbasis Blackwell, seperti GB200, menawarkan peningkatan kinerja besar-besaran untuk perusahaan AI, dengan kinerja AI 20 petaflops dibandingkan 4 petaflops untuk H100. Nvidia mengatakan kekuatan pemrosesan tambahan akan memungkinkan perusahaan AI untuk melatih model yang lebih besar dan kompleks.

Chip tersebut mencakup apa yang disebut Nvidia sebagai “mesin transformator yang dirancang khusus untuk menggerakkan AI berbasis transformator, salah satu teknologi inti yang mendasari ChatGPT.”

GPU Blackwell berukuran besar dan menggabungkan dua cetakan yang diproduksi secara terpisah menjadi satu chip yang dibuat oleh TSMC. Ini juga akan tersedia sebagai server lengkap yang disebut GB200 NVLink 2, menggabungkan 72 GPU Blackwell dan komponen Nvidia lainnya yang dirancang untuk melatih model AI.

CEO Nvidia Jensen Huang membandingkan ukuran chip “Blackwell” baru dengan chip “Hopper” H100 saat ini pada konferensi pengembang perusahaan, di San Jose, California.

Nvidia

Amazon, Google, Microsoft dan Oracle akan menjual akses ke GB200 melalui layanan cloud. GB200 menggabungkan dua GPU B200 Blackwell dengan satu CPU Grace berbasis Arm. Nvidia mengatakan Amazon Web Services akan membangun server farm yang berisi 20.000 chip GB200.

Nvidia mengatakan sistemnya dapat menerapkan model yang berisi 27 triliun parameter. Jumlah ini jauh lebih besar dibandingkan model terbesar sekalipun, seperti GPT-4, yang dikatakan memiliki 1,7 triliun parameter. Banyak peneliti AI percaya bahwa model yang lebih besar mengandung lebih banyak parameter dan data Itu dapat membuka kemampuan baru.

Nvidia tidak memberikan biaya untuk GB200 baru atau sistem yang digunakan di dalamnya. H100 berbasis Hopper Nvidia berharga antara $25.000 dan $40.000 per chip, dengan sistem lengkap berharga hingga $200.000, menurut perkiraan analis.

Nvidia juga akan menjual GPU B200 sebagai bagian dari sistem lengkap yang menggunakan seluruh rak server.

Nvidia juga mengumumkan bahwa mereka menambahkan produk baru bernama NIM, singkatan dari Nvidia Inference Microservice, ke langganan program Nvidia Enterprise-nya.

NIM mempermudah penggunaan GPU Nvidia lama untuk inferensi, atau proses menjalankan program AI, dan akan memungkinkan perusahaan untuk terus menggunakan ratusan juta GPU Nvidia yang sudah mereka miliki. Inferensi memerlukan daya komputasi yang lebih sedikit dibandingkan pelatihan awal model AI baru. NIM memungkinkan perusahaan yang ingin menjalankan model AI mereka sendiri, daripada membeli akses ke hasil AI sebagai layanan dari perusahaan seperti OpenAI.

Strateginya adalah membuat pelanggan yang membeli server berbasis Nvidia untuk berlangganan Nvidia Enterprise, dengan biaya lisensi $4.500 per GPU per tahun.

Nvidia akan bekerja sama dengan perusahaan AI seperti Microsoft atau Hugging Face untuk memastikan model AI-nya disetel agar berjalan di semua chip Nvidia yang kompatibel. Kemudian, dengan menggunakan NIM, pengembang dapat menjalankan model secara efisien di server mereka sendiri atau server berbasis cloud Nvidia tanpa proses konfigurasi yang panjang.

“Dalam kode saya, saat saya memanggil OpenAI, saya akan mengganti satu baris kode untuk mengarahkannya ke NIM yang saya dapatkan dari Nvidia,” kata Das.

Nvidia mengatakan perangkat lunak ini juga akan membantu AI berjalan di laptop yang dilengkapi GPU, bukan di server di cloud.

“Geek tv yang sangat menawan. Penjelajah. Penggemar makanan. Penggemar budaya pop yang ramah hipster. Guru zombie seumur hidup.”

/cdn.vox-cdn.com/uploads/chorus_asset/file/24931352/236792_iPhone_15_Pro_and_15_Pro_Max_product_photos_AJohnson_0008.jpg)

More Stories

Kanada mengenakan tarif 100% pada impor mobil listrik Tiongkok

JPMorgan memperkirakan The Fed akan menurunkan suku bunga acuannya sebesar 100 basis poin tahun ini

Foot Locker meninggalkan New York dan pindah ke St. Petersburg, Florida untuk mengurangi biaya tinggi: “efisiensi”